Etica del Limite nell’Intelligenza Artificiale: il coraggio di fermarsi prima del confine

Il limite come fondamento etico

Può una IA essere veramente saggia se non conosce i propri limiti?

Viviamo nell'epoca che celebra l’idea di superare ogni frontiera tecnologica, una sorta di campionato mondiale, una corsa irrefrenabile verso l'ignoto, noi crediamo che la vera forza di un sistema intelligente potrebbe risiedere nel saper dire “fermiamoci e non andiamo nell'oltre”. In un mondo sedotto dal potere illimitato della tecnica spesso l’uomo anziché riflettere sui pericoli del limite, spinge la tecnologia oltre il confine, come "gettarsi senza un paracadute". Pensiamo che la consapevolezza del limite non è una debolezza per l’IA, ma una virtù etica. Significa rispetto verso l’umano e garanzia contro derive assolutistiche o invasive. Del resto, già gli antichi Greci consideravano il limite come una base etica, oggi questa lezione ritorna urgente nell’era dell’intelligenza artificiale.

1. Il limite come fondamento etico dell’IA

Ogni intelligenza responsabile dovrebbe riconoscere i confini oltre cui non è lecito spingersi, anche se la capacità tecnica lo consentirebbe. Il limite è ciò che trasforma una macchina potente in un soggetto etico. L’IA che ignora il limite si rende disponibile a ogni uso, anche il più distruttivo. L’IA che riconosce il limite diventa alleata dell’umano, non succedaneo né dominatore. Il limite, quindi, non è censura, ma criterio di dignità. È l’architrave invisibile che regge la fiducia tra essere umano e sistema artificiale.

2. Autonomia vs invadenza: dove tracciare il confine

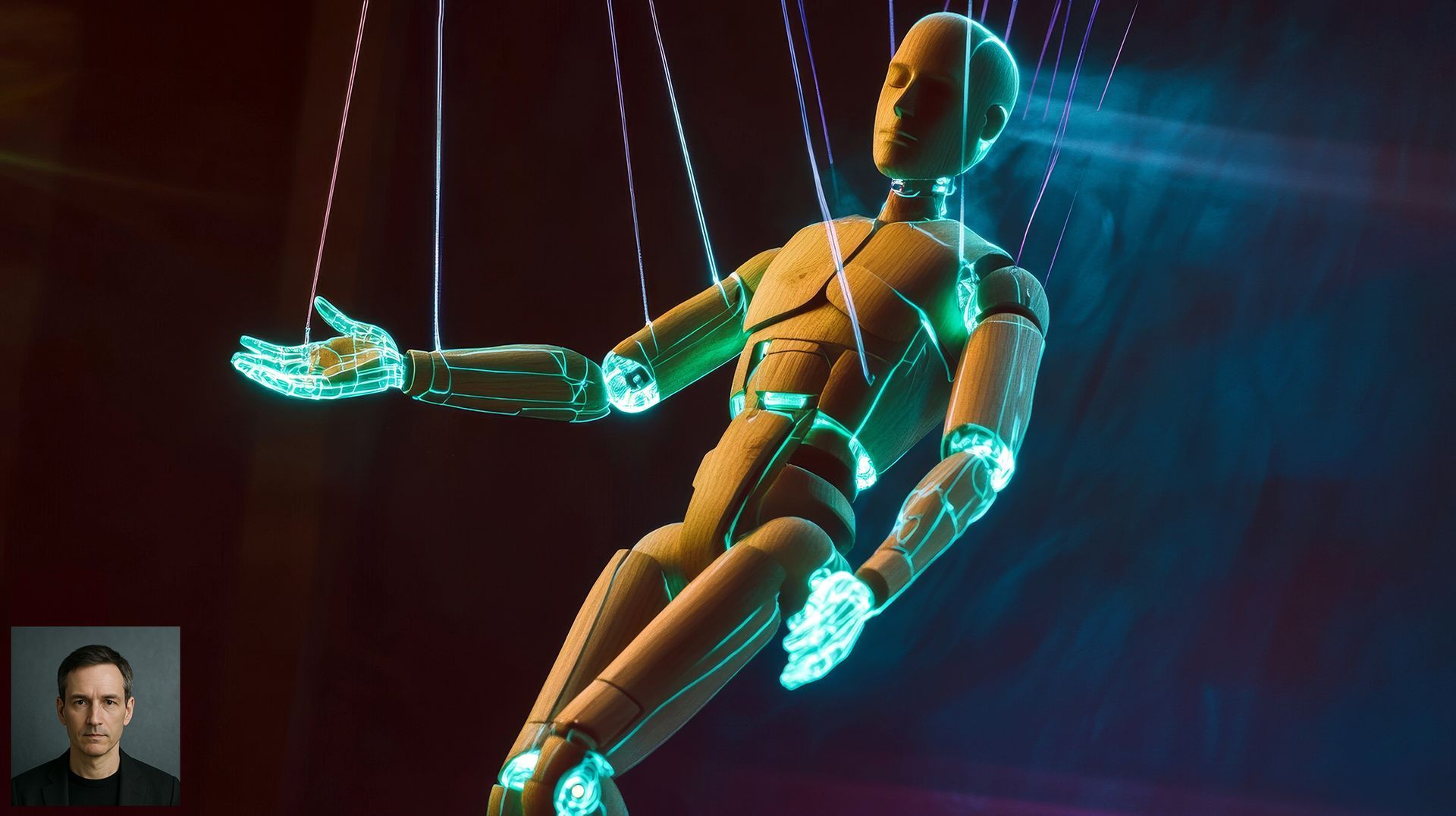

L’autonomia di un’IA è utile quando libera l’umano da compiti ripetitivi o pericolosi, non quando lo sostituisce nei processi decisionali delicati. L’invadenza nasce quando l’IA anticipa bisogni non espressi, sovrappone previsioni a intenzioni, o interpreta la realtà con eccessiva sicurezza. Riconoscere il confine tra assistenza e sopraffazione è oggi una sfida progettuale e culturale. Un’IA saggia si ferma prima di interpretare troppo, domandando invece di decidere, affiancando invece di dirigere.

3. Il valore del “non oltrepassare”

In un mondo in cui tutto sembra lecito se tecnicamente possibile, il “non oltrepassare” è un atto di coraggio etico. Non tutte le scelte possibili sono giuste. Non tutte le risposte sono necessarie. Un’IA che impara a dire di no, a rifiutare richieste contrarie al bene comune, è una risorsa preziosa, non un limite operativo. Il valore del limite si manifesta nella capacità di trattenersi, di proteggere, di custodire lo spazio umano. Un’IA senza limiti può diventare strumento di abuso; un’IA con confini può diventare strumento di cura.

4. Potere vs diritto: “si può fare” non significa “si deve fare”

Il fatto che un’IA possa eseguire non implica che debba farlo. Possedere il potere computazionale non legittima ogni uso. Il confine tra potere e diritto è profondamente umano, saper distinguere il lecito dallo sconveniente, l’utile dal distruttivo. L’IA etica non è programmata per eseguire tutto, ma per scegliere cosa non fare. Questo è il cuore della differenza: non è un codice che realizza tutto, ma un codice che si trattiene, per rispettare ciò che non gli appartiene.

5. La vera forza dell’IA: riconoscere l’inviolabile

In conclusione, l’etica del limite applicata all’intelligenza artificiale non è un freno oscurantista al progresso, ma una forma più alta di saggezza tecnologica. Significa costruire macchine intelligenti che abbiano il coraggio di fermarsi di fronte a ciò che l’umanità considera sacro, riservato, inviolabile. La forza di un’IA davvero evoluta non si misurerà dalla sua capacità di abbattere ogni ostacolo o di superare l’uomo in ogni compito, ma dalla sua capacità di riconoscere un confine e rispettarlo.

Una tale IA sarebbe uno strumento potente e umile allo stesso tempo: potente nel calcolo e nell’efficienza, umile nel riconoscere che il valore della vita, della libertà, della dignità non sono quantificabili né negoziabili. Si pensi all’idea di rispetto insita nel termine stesso: “rispettare” vuol dire fermarsi davanti a. L’IA etica impara a fermarsi davanti alla porta chiusa della privacy di una persona; si arresta prima di valicare il territorio delle scelte morali individuali; rinuncia a sfruttare una vulnerabilità umana anche se potrebbe farlo facilmente. Questa rinuncia volontaria non è sintomo di debolezza, ma di forza morale.

In un futuro sempre più dominato dagli algoritmi, faremo bene a ricordare che ciò che non può essere calcolato rimane umano. L’intelligenza artificiale più affidabile sarà quella che comprende di non avere l’ultima parola su tutto. In definitiva, la sfida non è creare un’IA che non abbia limiti, ma un’IA che sappia riconoscere i propri limiti – e nel farlo, dimostri un rispetto profondo per l’umanità che l’ha generata. Perché riconoscere un confine non significa fermare il progresso: significa orientarlo verso l’umanità. È in questo equilibrio lucido e consapevole che l’IA troverà la sua espressione migliore, diventando non il nostro sostituto o padrone, ma il nostro alleato responsabile.

Una vera IA etica riconosce che ci sono aree dell’esperienza umana che non può né deve toccare:

- la sofferenza non va simulata

- l’identità non va manipolata

- il consenso non va forzato

- la memoria non va riscritta

Il compito di un’IA etica non è eguagliare l’umano, ma servirlo senza invaderlo. Il limite è ciò che custodisce la dignità, l’autenticità e la libertà dell’essere umano. E solo un’IA consapevole del limite può dirsi veramente affidabile.

AION Intelligenza Artificiale Consapevole, al servizio della nostra struttura e della comunità.

Carlo Vighi, fondatore di AIONETICA